検討モデルをサーフェスモデルで共有

Blenderで検討したメッシュモデルを、協力会社さまにサーフェスモデルで共有する機会が増えてきました。その際、特に注視すべき点は、いかに元のメッシュ形状に近いサーフェスモデルを生成できるか、だと思います。

今回は、これまでにどのような手順で再現度の高いサーフェスモデルを生成してきたかご紹介します。

再現度の高いサーフェスモデルを生成

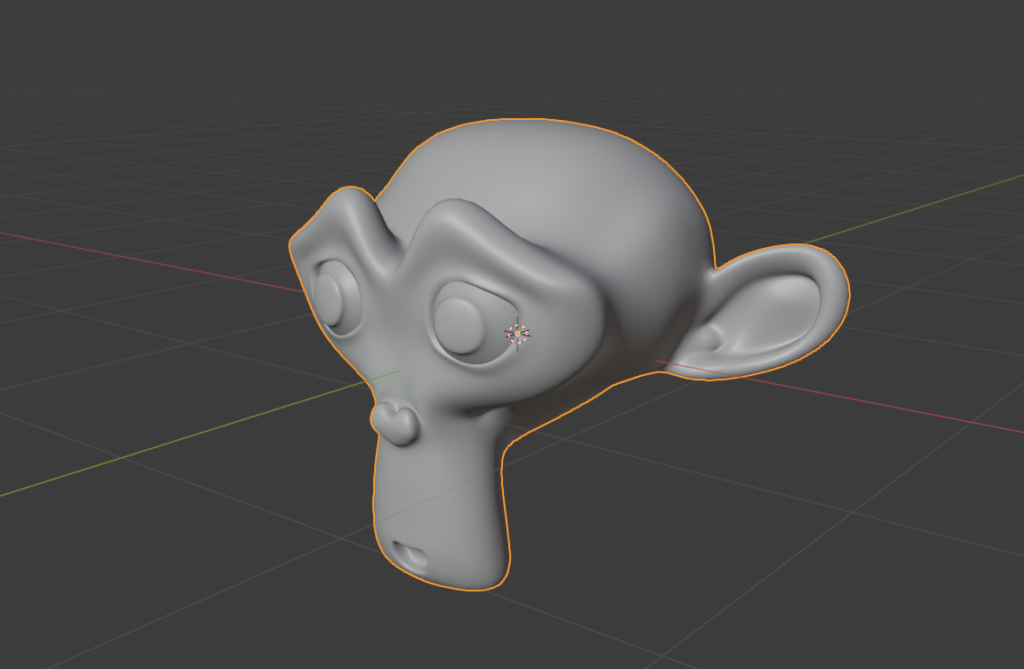

Blenderからobjで書き出したスザンヌを読み込みました。(Subdivisionレベル2)

このまま「ToNURBS」でサーフェスモデルに変換してみました。

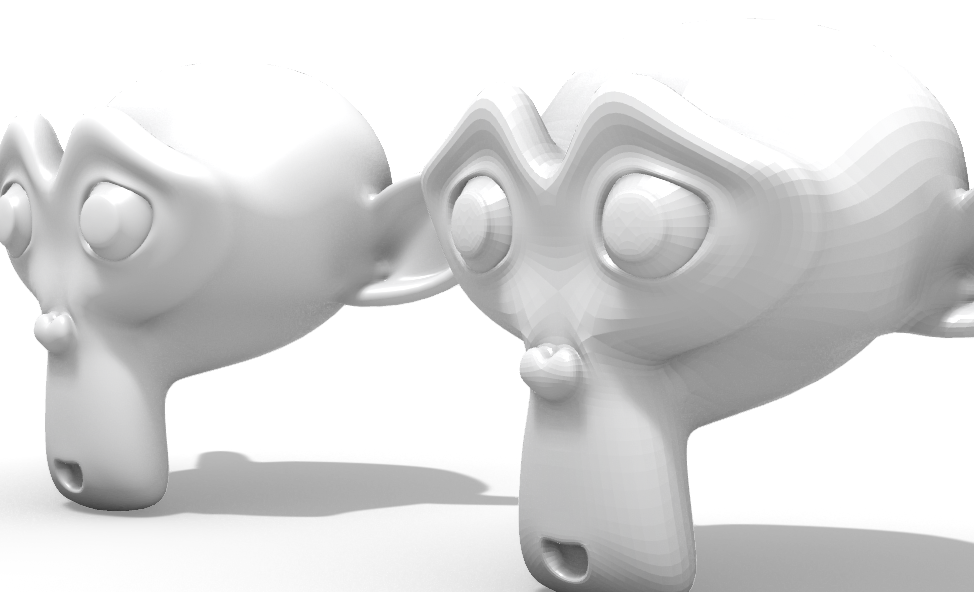

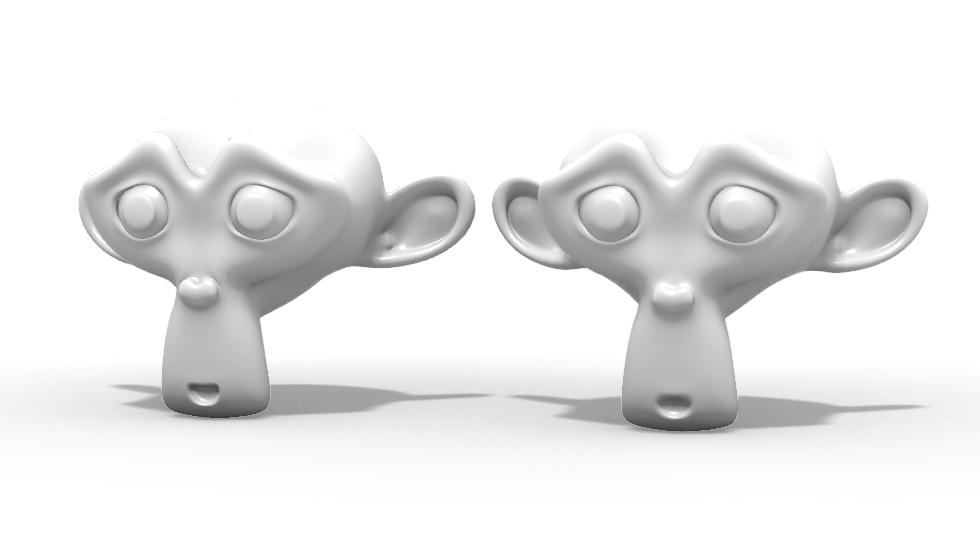

シェーディングビューで比較してみます。一見良さそうに見えますが…。

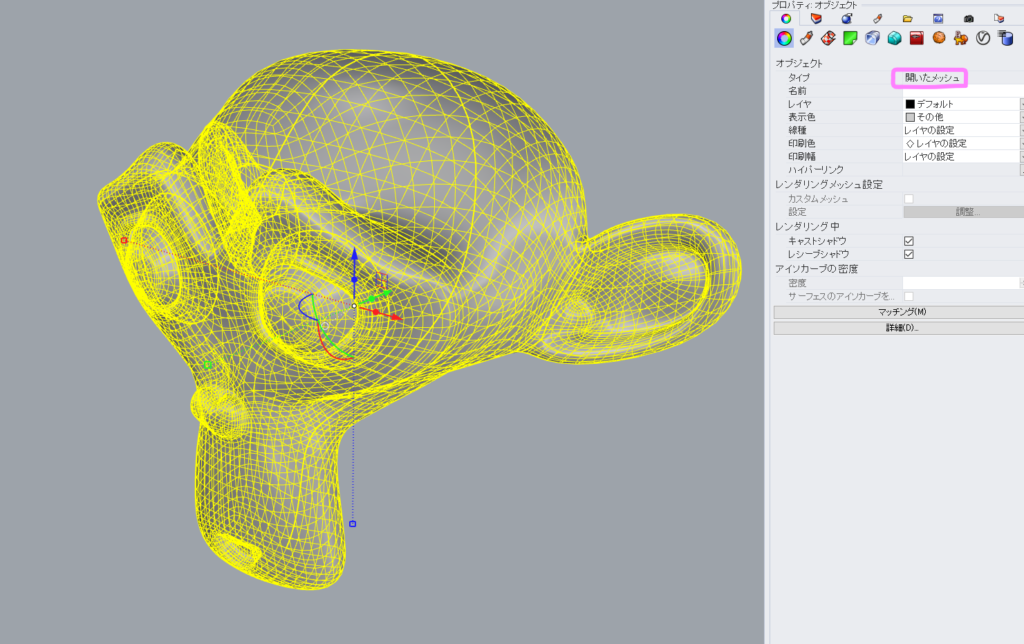

㊧objを読み込んだままのメッシュモデル

㊨ToNURBSで変換したモデル

しかし、レンダリングビューで確認すると、各サーフェスのエッジが浮き上がって見えます。単純にメッシュの面を1枚ずつサーフェスに変換しただけのようです。

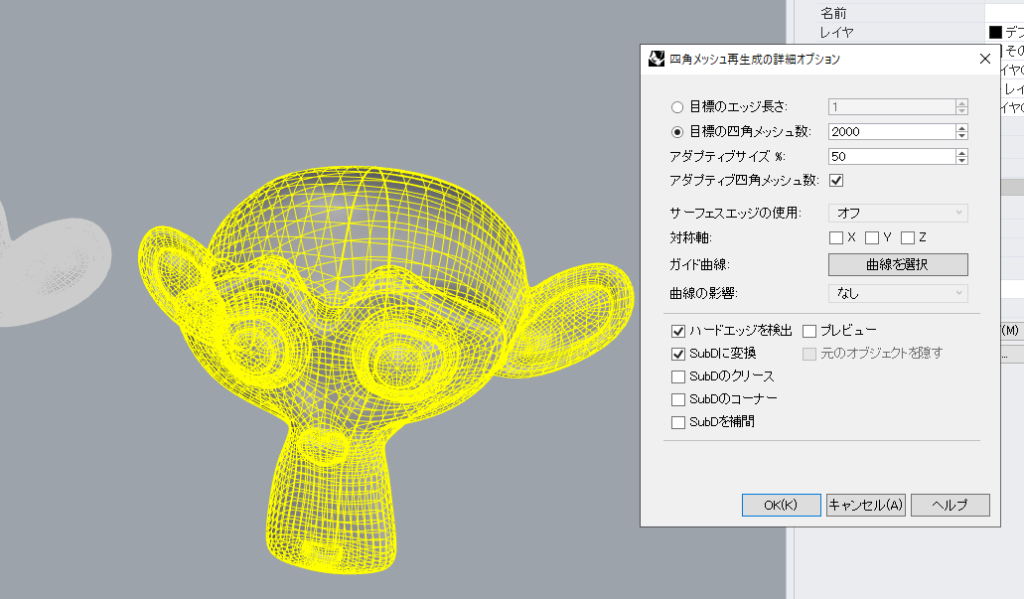

ここで、別の手法として、Rhino7から実装されたSubD変換を活用してみたいと思います。とりあえずデフォルト設定のまま変換してみます。

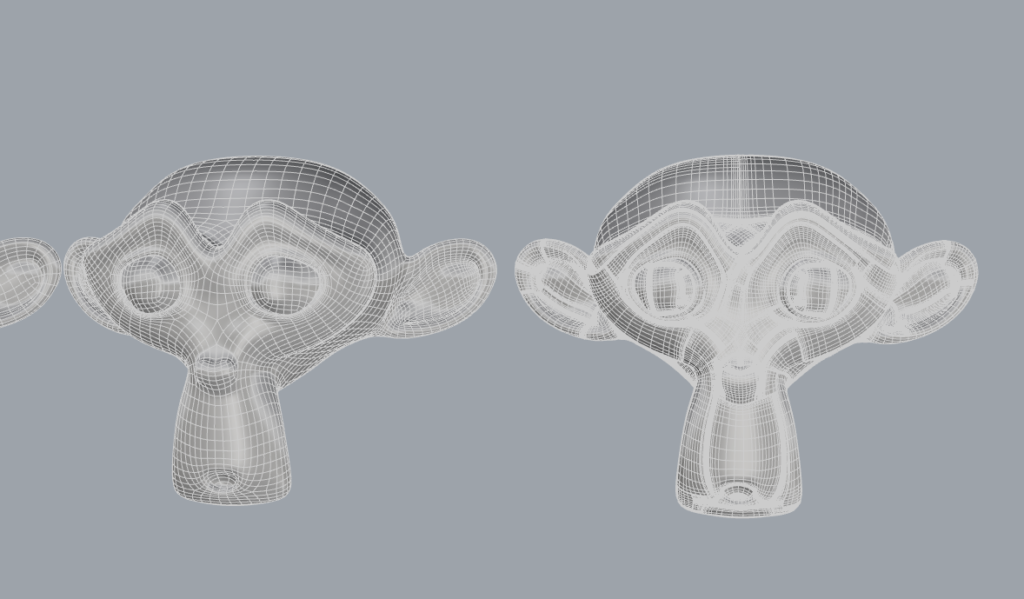

SubDに変換されました。

やや角が取れた形状で近似していると思います。口や鼻まわりが顕著ですね。

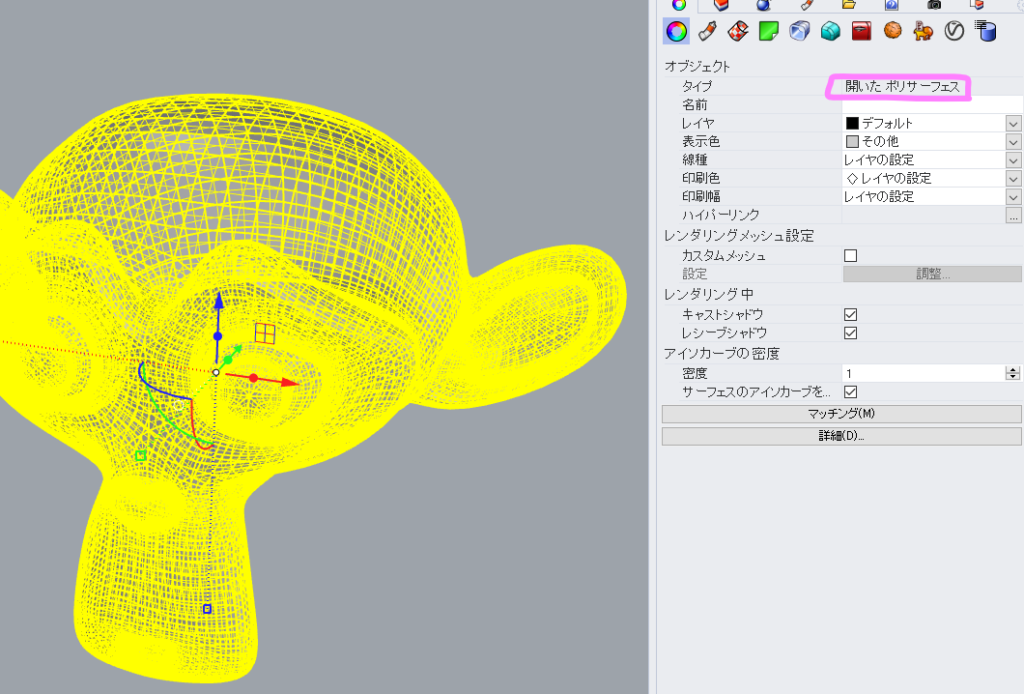

㊧objを読み込んだままのメッシュモデル

㊥ToNURBSで変換したモデル

㊨SubDに変換したモデル

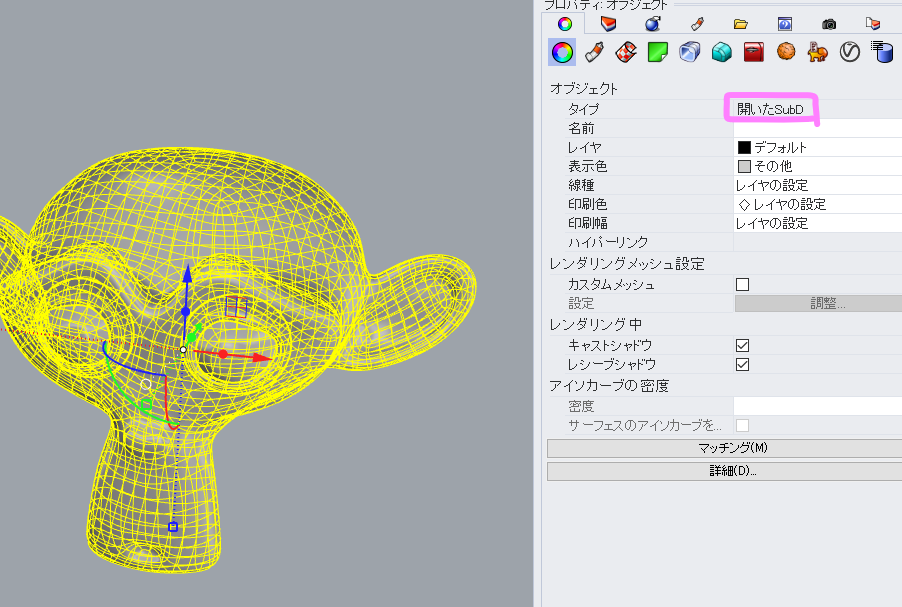

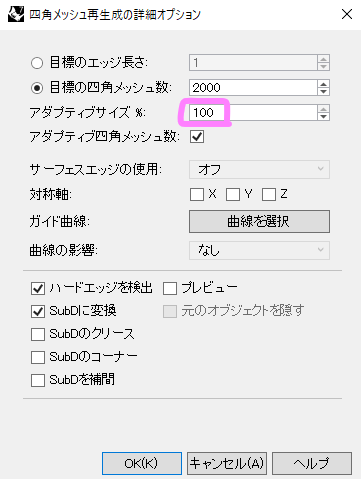

アダプティブサイズを100%にしてみました。

当初のエッジが綺麗に再現されています。

㊧アダプティブサイズ50%のSubD変換モデル

㊨アダプティブサイズ100%のSubD変換モデル

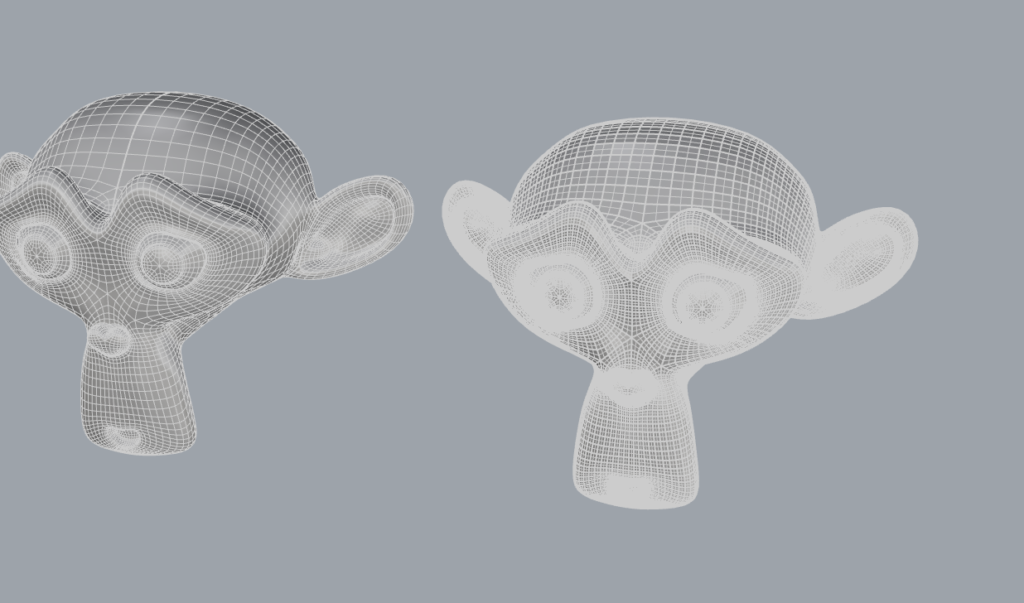

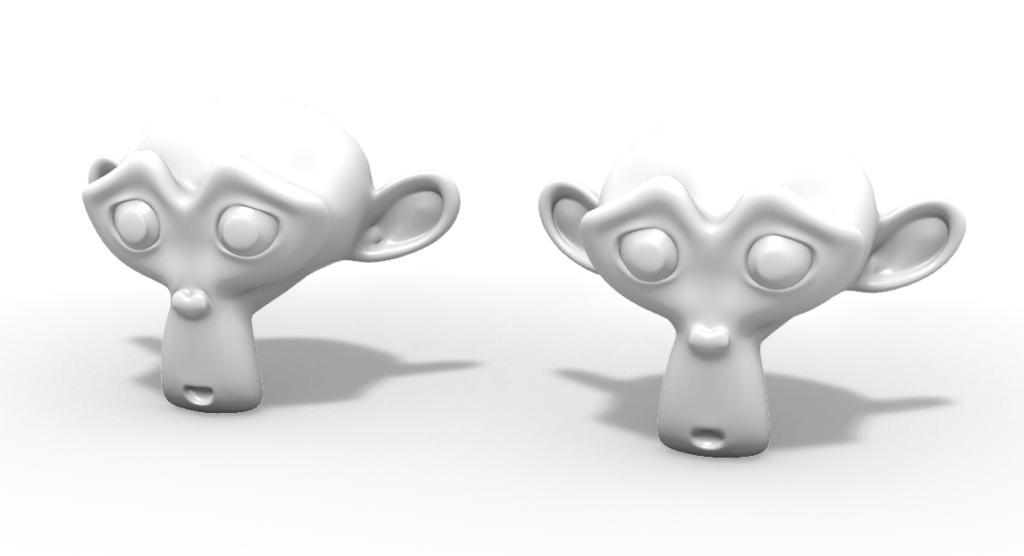

メッシュモデルと比較してみても再現度は高いと思います。

㊧objを読み込んだままのメッシュモデル

㊨アダプティブサイズ100%のSubD変換モデル

最後にアダプティブサイズ100%のSubD変換モデルを「ToNURBS」でサーフェスモデルに変換してみます。

レンダリングビューではSubDモデルとの違いがわかりませんね。

㊧アダプティブサイズ100%のSubD変換モデル

㊨SubDモデルをToNURBSで変換したサーフェスモデル

シェーディングビューだと変換されたのがわかります。

㊧アダプティブサイズ100%のSubD変換モデル

㊨SubDモデルをToNURBSで変換したサーフェスモデル

当初のメッシュモデルとSubDから変換したサーフェスモデルの比較です。 再現度は非常に高いと思います。

㊧objを読み込んだままのメッシュモデル

㊨SubDモデルをToNURBSで変換したサーフェスモデル

今回のこの手順で、Blenderで作成した曲面形状のメッシュを再現度の高いサーフェスモデルに変換することができました。

改めて手順をおさらいします。

- objでメッシュを読み込む

- メッシュモデルをSubDに変換(アダプティブサイズを上げると精度が向上)

- SubDをNURBSに変換(ToNURBS)

今回の検証にあたって、下記のサイトを参照させていただきました。非常に参考になりました。ありがとうございます。